Софт по анимации персонажей Cascadeur достиг аудитории в 130 тысяч человек и сегодня выходит в Product Hunt. Мы подумали, что это отличный повод поговорить с его основателем про вызовы, которые сейчас стоят перед инструментом, и, главное, про его интеграцию с нейросетями.

Cascadeur

Александр Семенов, главный редактор App2Top: Женя, привет! Смотри, еще с декабря хотел поговорить с командой Cascadeur на тему графических нейросетей. Вы, кстати, как к ним вообще относитесь?

Евгений Дябин

Евгений Дябин, основатель и главный продюсер Cascadeur: Относимся с большим интересом и даже ресерчим их для наших задач. Если говорить глобально, то я не разделяю панику по поводу внезапной технологической революции с исчезновением многих профессий. Появление фотоаппаратов не уменьшило число художников, а появление камер с автонастройкой в каждом телефоне не уменьшило число профессиональных фотографов и операторов, хотя и изменило их работу. К тому же, пока эти новые нейронные сети обладают множеством проблем и ограничений, если пытаешься применить их на практике – это сильно охлаждает первое впечатление. Посмотрим, насколько быстрым будет прогресс.

Отлично. Так вот, желание было, повода — нет. И вот сегодня вы релизитесь на Product Hunt. Отличный повод, с которого и начнем. Зачем нужен Product Hunt?

Евгений: Дело в том, что Product Hunt – это целое сообщество, где собираются и общаются мейкеры, стартаперы и энтузиасты. Каждый день они оценивают и обсуждают новые продукты, и их оценка много значит для различных профильных СМИ.

Кстати, пользуясь случаем обращусь к читателям – если вы хотите поддержать наш проект, то вы можете сделать это сегодня на сайте Product Hunt и даже оставить свой фидбек или вопрос – мы обязательно на все ответим.

Сегодня Cascadeur выходит на Product Hunt

Пользовательская база Cascadeur – 130 тысяч человек. Вы сами говорили, что к вам выстраивалась очередь из игровых и кинокомпаний. Чего даст Product Hunt, чего вы еще не достигли сами?

Евгений: Да, про нас знают и крупные студии, и инди-разработчики – узнаваемость у нас высокая. Но есть серьезный порог между знанием о софте и решением взяться за его изучение. Если мы получим на Product Hunt награду «продукт дня», то это будет играть роль социального доказательства от экспертного сообщества. Мне кажется, это позволит нам иначе позиционировать себя для крупных СМИ и убедить больше людей попробовать Cascadeur.

В декабре у Cascadeur был официальный мировой релиз после года беты. С какими вызовами вы столкнулись как сервис после этого?

Евгений: Релиз привел к большому наплыву пользователей, и это значительно увеличило нагрузку на поддержку. Вопросов посыпалось очень много, а количество специалистов осталось прежним, и не так легко их масштабировать – они должны хорошо разбираться в программе и технических деталях.

Поэтому мы делаем FAQ, чтобы ускорить поддержку «первой линии», а также приоритезируем поддержку пользователей Pro-версии – при оформлении лицензии они будут сразу получать ссылку на закрытый канал. В общем, оптимизируем процесс.

Еще мы впервые столкнулись с тем, что некоторым компаниям нужно купить сразу 40 лицензий, например. Пришлось срочно доделывать такой функционал. Также, оказалось, что 20% наших пользователей – это студенты или работники в сфере образования, поэтому нам надо добавить учебные лицензии.

Вы, наверное, собираете фидбэк. Исходя из него, чего в Cascadeur сегодня обычно не хватает пользователям?

Евгений: Пользователям не хватает тысячи мелочей, и все сделать невозможно. Поэтому нам приходится выбирать что-то наиболее востребованное или важное на наш взгляд. Например, улучшение совместимости с Blender или возможность загрузить аудио. Есть очень частые, но сложные запросы типа лицевой анимации или блендшейпов, которые рано или поздно надо будет сделать, но пока нам не хватает ресурсов.

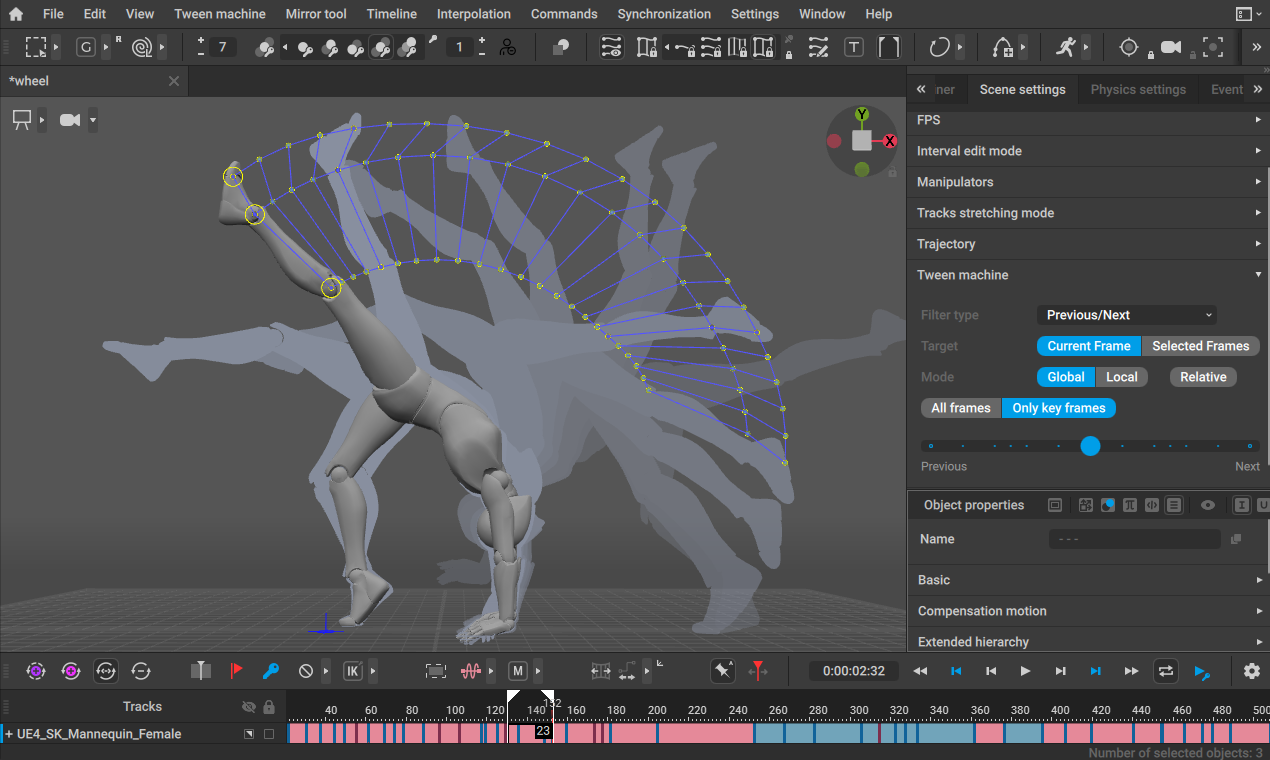

Что касается нашей главной темы – физики, то многие пользователи ожидают увидеть рэгдолл, коллизии и взаимодействие с окружением. Пока наша Автофизика занимается коррекцией динамического равновесия в движениях, коррекцией траектории и вращения в прыжках, добавлением вторичных колебаний и захлестов – это сильно улучшает анимацию и ускоряет работу над ней. Но пока действительно не хватает возможности отталкиваться от стен, залезать на уступы или взаимодействовать с другими персонажами. Над всем этим мы активно работаем.

Еще некоторые пользователи жалуются на неудобство работы с пальцами персонажа из-за необходимости поворачивать каждую фалангу. Но уже в ближайшем обновлении мы добавим Автопозинг пальцев – умный риг, позволяющий очень легко управлять пальцами через несколько контроллеров.

Я немного поделюсь своей болью. Когда я увидел, на что способна связка Stable Diffusion — ControlNet — Blender, я тут же подумал о Cascadeur. В отличие от Blender он заточен именно на позинг, и порог вхождения у него, уверен, меньше, чем у Blender (и он точно удобнее, чем базовый функционал ControlNet). В связи с этим вопрос: стоит ли ждать поддержки SD в Cascadeur?

Евгений: Эта идея лежит на поверхности! Мы тоже об этом сразу подумали! И не только нам. Однако только у нас есть самый удобный инструмент для управления позой персонажа, подходящий для новичков и любителей. Нам остается только добавить к этому нейрорендеринг на базе Stable Diffusion, который превратит 3d-модель в готовую 2d-картинку в любом стиле. В общем, мы уже работаем над этим.

Мы всегда хотели выйти на более широкую аудиторию, но проблема Cascadeur в том, что он не выдает конечный продукт, а является лишь звеном в производственной цепочке. Но нейрорендеринг может стереть эту грань для широкой аудитории, особенно в мобильной версии Cascadeur. Ты скачиваешь мобильное приложение, ставишь достаточно натуральную позу с помощью Автопозинга, выбираешь ракурс камеры, загружаешь картинку персонажа и получаешь этого персонажа в необходимой позе с нужного ракурса. Это даст намного больший творческий контроль, чем в принципе возможно с помощью текстового описания. Пока речь только о картинках, но когда-нибудь дело дойдет и до видео, и в этом преимущества Cascadeur проявятся в полную силу.

Cascadeur

Уже сейчас появляются первые нейросети, способные делать видео. Два-три года и, скорее всего, мы увидим первые полноценные короткометражки. Но, будут ли они построены на принципе text-to-animation или на принципе text+animation-to-animation, где в роли промта также будет выступать анимированный мокап?

Евгений: Пока я скептически отношусь к тому, что в ближайшее время нейронные сети смогут генерировать качественную 3d-анимацию, не прибегая к физической симуляции. Мы рассматриваем text-to-animation как первичный драфт, который мы можем почистить, поправить позы и физику – и получить качественную анимацию, которую пользователь может редактировать с помощью наших инструментов. Не представляю, как без дополнительного контроля можно получить необходимый результат из одного лишь текста, кроме самых тривиальных случаев.

Если добавить к этому нейрорендеринг видео, который рано или поздно станет возможным, то инструмент получается достаточно волшебным. Ты словами описываешь идею, получаешь достаточно реалистичный вариант, редактируешь его и на выходе имеешь готовое видео с нужным персонажем в любом стиле. Но пока это все концепт, и до реализации еще далеко.

Cascadeur сам был построен на базе нейросетей. Иными словами, вы в этой теме давно. Однако применяли ли вы их только в рамках обучения своего сервиса? Или где-то (в каких-то иных областях) еще с ними экспериментировали?

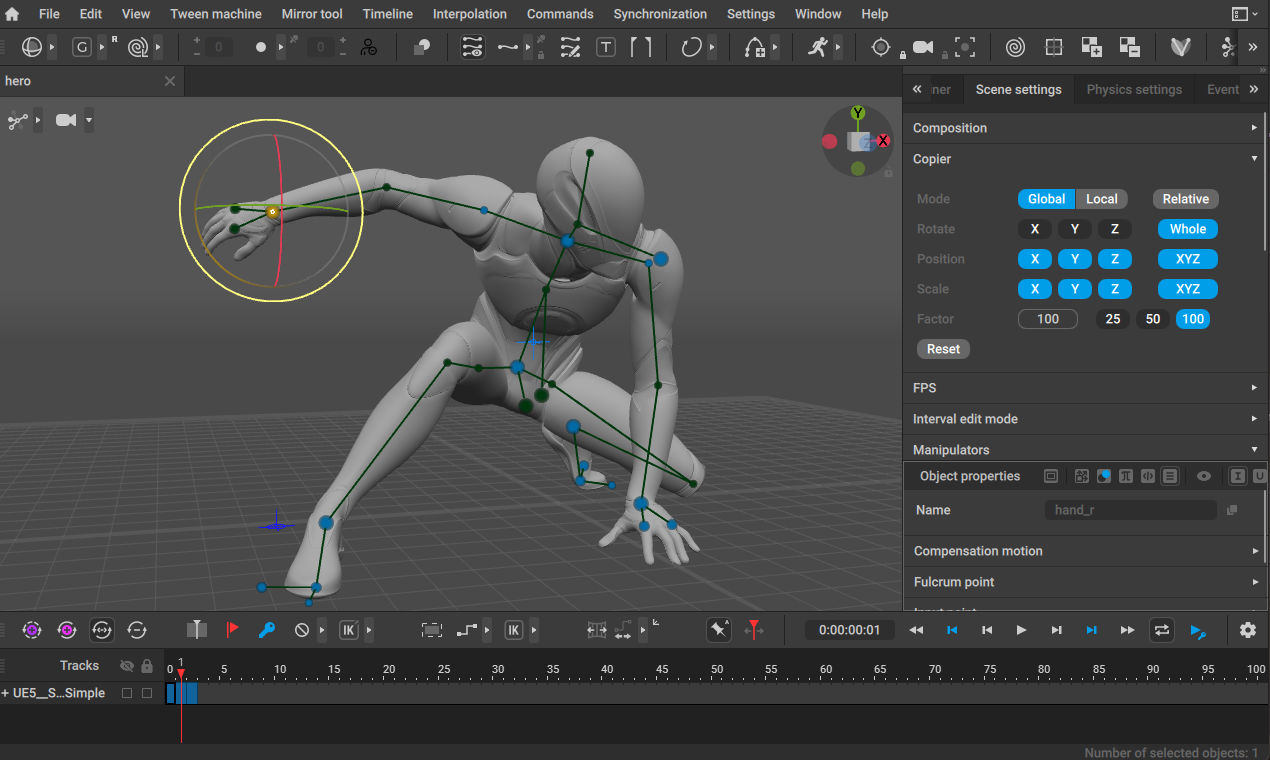

Евгений: Во-первых, хочу отметить, что пока в Cascadeur физики больше, чем нейросетей, и это главное отличие от большинства известных нам решений для генерации движений. Нейронные сети мы стали применять несколько лет назад и наибольших успехов достигли в инструменте Автопозинга, который помогает сделать натуральную позу наименьшим количеством действий.

Если говорить про компанию Nekki в целом, то нейронные сети стали применять и в других проектах для разных задач. В качестве примера могу назвать ботов в Shadow Fight 4: Arena. Они обучены на боях игроков и умеют управлять разными персонажами, используя их спецприемы и характерную для этих персонажей тактику.

Многие анимации в Cascadeur делаются так: в программу загружается в качестве шаблона видеоролик, по которому аниматор воспроизводит ключевые кадры. Насколько реально в рамках вашего сервиса реализовать модель, которая будет готова делать черновой вариант анимации по одному лишь видео? Работаете ли в этом направлении?

Евгений: Да, работаем над этим – это что-то типа мокапа по видео. Уже в следующей версии Cascadeur будет первая альфа-версия этой фичи. Пока добиться хорошего качества не получается, но как драфт анимации по референсу, в котором есть хотя бы ключевые позы и тайминги, – это может очень сильно экономить время. Мы будем развивать и оптимизировать эту фичу. На клиенте она работает медленно, поэтому надо переносить ее на сервер – тогда мы будем меньше ограничены производительностью.

Cascadeur

Возвращаясь к бизнесу: сейчас говорят, что инвесторы как ненормальные бегут вкладывать в AI. Ощутили ли вы это на своем опыте? Чего ждут такие инвесторы, которые должны понимать, что они по сути соревнуются с Microsoft, Google и Adobe на этом поприще?

Евгений: Я думаю, что соревнования с гигантами тут нет. Крупные компании вкладываются в саму технологию, а небольшие компании и стартапы пытаются эту технологию использовать в разных сферах. Мы также не разрабатываем с нуля наш нейрорендеринг или мокап по видео, а используем доступные библиотеки и модели, настраивая и дообучая их под свои задачи.

Мне кажется, инвестиции в такие проекты сейчас сильно возрастут. Мы финансируемся компанией Nekki, но тоже открыты к предложениям.

Кстати, вы сами ожидали такого внимания к нейросетям, которое они получили после популяризации MJ, SD и ChatGPT?

Евгений: Мы еще несколько лет назад понимали, что будущее за нейросетями и их внедрением в разные инструменты, поэтому и стали набирать датасайентистов и заниматься ресерчем и разработкой своих инструментов, чтобы быть готовыми к революции. Но успехи Midjourney и ChatGPT все равно удивили нас и дали новые надежды и идеи вроде нейрорендеринга, text-to-animation и других.

Какой-то прогноз готовы дать? Чего ждать в рамках AI-технологий, в том числе вашей собственной, хотя бы до конца года?

Евгений: Мне кажется, мир и рынок не изменится так быстро, как многие боятся, но прежде всего изменится инвестирование, которое отражает веру в определенное будущее. В ближайший год я бы ожидал появление интеллектуального поиска и изменение подхода к туторам – теперь люди смогут получать персональную помощь и инструкции в своих задачах. Генеративные сети помогут быстрее прототипировать и пробовать разные идеи, но финальный результат в большинстве случаев выдавать не смогут.

Что касается нас, то мы рассматриваем AI именно как ассистента, ускоряющего работу аниматора, который знает, что хочет получить. Распознавание движения с референса, Автопозинг, Автофизика, нейрорендеринг – все это в первую очередь сокращение времени между идеей и результатом, но на каждом этапе аниматор имеет полный контроль и может вносить любые изменения. Думаю, до конца года мы уже сможем похвастаться новыми AI-фичами.

И два технических вопроса: при знакомстве с ограничениями бесплатной версией, я обратил внимание, что пользователь может экспортировать модели только с «300 frames and 120 joints». Для тех, кто не знаком с анимацией, объясни, это сколько?

Евгений: Вот так, от сказочного будущего к насущной необходимости окупать разработку! Идея ограничений такова, чтобы дать возможность любителям и инди-разработчикам пользоваться Cascadeur бесплатно, не лишая их важного функционала. 300 кадров при 30 кадрах в секунду – это 10 секунд. Этого более чем достаточно для игровых анимаций, но не хватит для длинных катсцен. Также, 120 джоинтов хватает практически для любого персонажа, но не хватит для нескольких персонажей или для очень навороченных.

Когда ждать поддержки Godot?

Евгений: Как только добавим поддержку формата glTF, сразу после поддержки формата USD. В общем, работаем над этим.

Комментарии

Ответить